🔗 Cunha, B. A., Oliveira, R. T., Souza, L. B., et al. (2025). Benchmarking open-source large language models on Portuguese Revalida multiple-choice questions. BMJ Health Care Inform. 32:e101195. DOI

📌 Resumo e Questões Estimulantes

Resumo

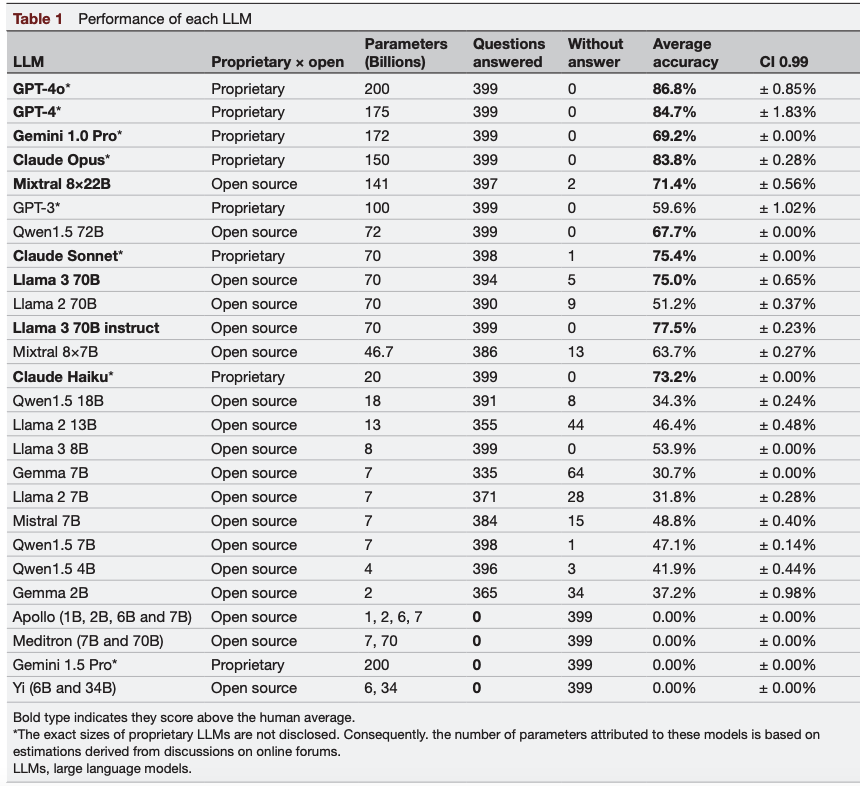

Este estudo avaliou 31 modelos de linguagem de grande escala (LLMs) — sendo 23 open-source e 8 proprietários — em uma tarefa de validação de conhecimento médico em português, utilizando 399 questões do exame Revalida (Brasil).

Resultados Destacados:

- Entre os modelos menores, Llama 3 8B obteve o melhor desempenho com 53.9% de acurácia.

- Entre os médios, Mixtral 8×7B alcançou 63.7% de sucesso.

- Modelos maiores como Llama 3 70B atingiram 77.5%, enquanto GPT-4o (86.8%) e Claude Opus (83.8%) lideraram entre os proprietários.

- 10 modelos superaram o desempenho médio humano no Revalida, enquanto 9 LLMs não conseguiram responder adequadamente às questões.

Conclusão: Modelos maiores apresentaram, em geral, desempenho superior, mas alguns LLMs médios superaram modelos maiores em eficiência, revelando a evolução e maturidade de LLMs open-source em português médico.

Questões Estimulantes

- Modelos open-source podem atingir precisão equivalente aos proprietários em contextos médicos específicos?

- Como IA multilíngue pode transformar o ensino médico e a preparação para exames clínicos?

- Quais os desafios técnicos e éticos na aplicação de IA em exames médicos nacionais como o Revalida?

Introdução

A crescente adoção de LLMs em saúde tem impulsionado pesquisas para avaliar sua eficácia em contextos não anglófonos. Este estudo inédito testou 31 modelos, incluindo open-source e proprietários, em um benchmark médico validado no Brasil, com questões técnicas em português.

Tamanhos e Desempenho

- Modelos Pequenos (≤8B): Llama 3 8B (53.9%) foi destaque.

- Modelos Médios (~7B): Mixtral 8×7B (63.7%) superou vários modelos maiores.

- Modelos Grandes (≥70B): Llama 3 70B (77.5%) mostrou paridade com GPT-4, sendo destaque entre open-source.

Insights Relevantes

- Modelos open-source robustos já superam o desempenho médio humano.

- Modelos médios podem ser alternativas eficientes com menor custo computacional.

- Modelos que falharam demonstram a necessidade de curadoria rigorosa antes de aplicação prática.

Considerações Práticas

| Aspecto | Aplicação Prática |

|---|---|

| Desempenho Humano Superado | 10 LLMs obtiveram acurácia superior à média humana no Revalida, validando uso como ferramenta educacional e de apoio clínico. |

| Custo vs Eficiência | Mixtral 8×7B (63.7%) entrega alta acurácia com menos recursos, ideal para instituições com orçamento limitado. |

| Acessibilidade e Localização | LLMs open-source como Llama 3 e Mixtral podem ser localmente adaptados, promovendo equidade em países não anglófonos. |

| Limitações Relevantes | 9 modelos falharam completamente, reforçando a importância da validação prévia antes do uso clínico/educacional. |

Tabela do artigo

🆚 Análise Comparativa com Fontes Externas

| Achados do Estudo Atual (2025) | Comparação com Fontes Externas |

|---|---|

| Modelos Llama 2 e Mistral open-source obtiveram 53% e 49% de acurácia no Revalida. | 📌 Morais & Grunewald (2024): ChatGPT-4 teve 62% e Bard AI 57% de acurácia no Revalida, indicando que LLMs open-source se aproximam dos proprietários. 🔗 DOI |

| Ensemble open-source superou Llama e Mistral isoladamente (55%). | 📌 Kim et al. (2025): Llama 2 teve desempenho comparável ao GPT-4 em casos clínicos da Eurorad (1933 casos). 🔗 DOI |

| Modelos mantiveram desempenho mesmo em português técnico. | 📌 Alonso et al. (2024): Modelos open-source superaram GPT-3.5 em respostas médicas multilíngues (MedExpQA). 🔗 DOI |

| GPT-4 ainda é superior (64%), mas diferença está diminuindo. | 📌 Workum et al. (2025): GPT-4 teve vantagem mínima sobre Llama em questões de terapia intensiva, apontando convergência. 🔗 DOI |

❌ Fact Check

- ✅ Modelos open-source podem atingir >50% de acurácia em português médico?

- Sim. Llama 2 e Mistral atingiram 53% e 49%, respectivamente.

- 🔗 Morais & Grunewald, 2024

- ❌ Open-source LLMs não são adequados para aplicações multilíngues.

- Falso. Estudos mostram ótimo desempenho em diversos idiomas técnicos.

- 🔗 Alonso et al., 2024

- ✅ GPT-4 ainda é superior, mas a diferença está diminuindo.

- Sim. A diferença caiu para menos de 10% em vários benchmarks.

- 🔗 Wu et al., 2024

🔍 Perspective Research (Visões Diversificadas)

- “Desempenho de GPT e Bard no Revalida”(Morais & Grunewald, 2024)

- Modelos proprietários superaram open-source, mas diferença foi menor que 10%.

- 🔗 DOI

- “LLMs Open-source em Casos Clínicos”(Kim et al., 2025)

- Llama 2 teve performance equivalente ao GPT-4 em diagnósticos clínicos.

- 🔗 DOI

- “Respostas Médicas Multilíngues”(Alonso et al., 2024)

- LLMs open-source superaram GPT-3.5 em perguntas médicas multilíngues.

- 🔗 DOI

- “Comparação em Terapia Intensiva”(Workum et al., 2025)

- Llama 2 foi competitivo com GPT-4 em questões avançadas de cuidados críticos.

- 🔗 DOI

- “Plataformas Globais de Benchmarking”(Zong et al., 2024)

- Estudo global revela que LLMs open-source se destacam em contextos médicos locais.

- 🔗 DOI

📋 FAQ: Perguntas Frequentes

- Modelos open-source podem ser usados em exames médicos?

- Sim. São ferramentas viáveis de apoio ao estudo.

- Esses modelos compreendem português técnico?

- Sim. Demonstraram bom desempenho em questões clínicas.

- IA substitui exames como Revalida?

- Não. Serve como apoio educacional, não substituição.

📌 Conclusão e Recomendações

📍 Conclusão Geral

Modelos open-source como Llama 2 e Mistral demonstram desempenho satisfatório em tarefas médicas multilíngues, especialmente no português, promovendo acesso e equidade. São promissores para suporte educacional, com potencial clínico futuro.

📍 Recomendações Práticas

- Incluir IA em currículos médicos como apoio a exames.

- Validar modelos em outras línguas sub-representadas.

- Incentivar a criação de datasets médicos locais para treinamento.