Suh et al. (2024) compare the accuracy of large language models and human readers in interpreting image inputs from the New England Journal of Medicine Image Challenge, highlighting the potential of AI in medical imaging (DOI: 10.1148/radiol.241668).

📜 Resumo e Questões Estimulantes

Resumo

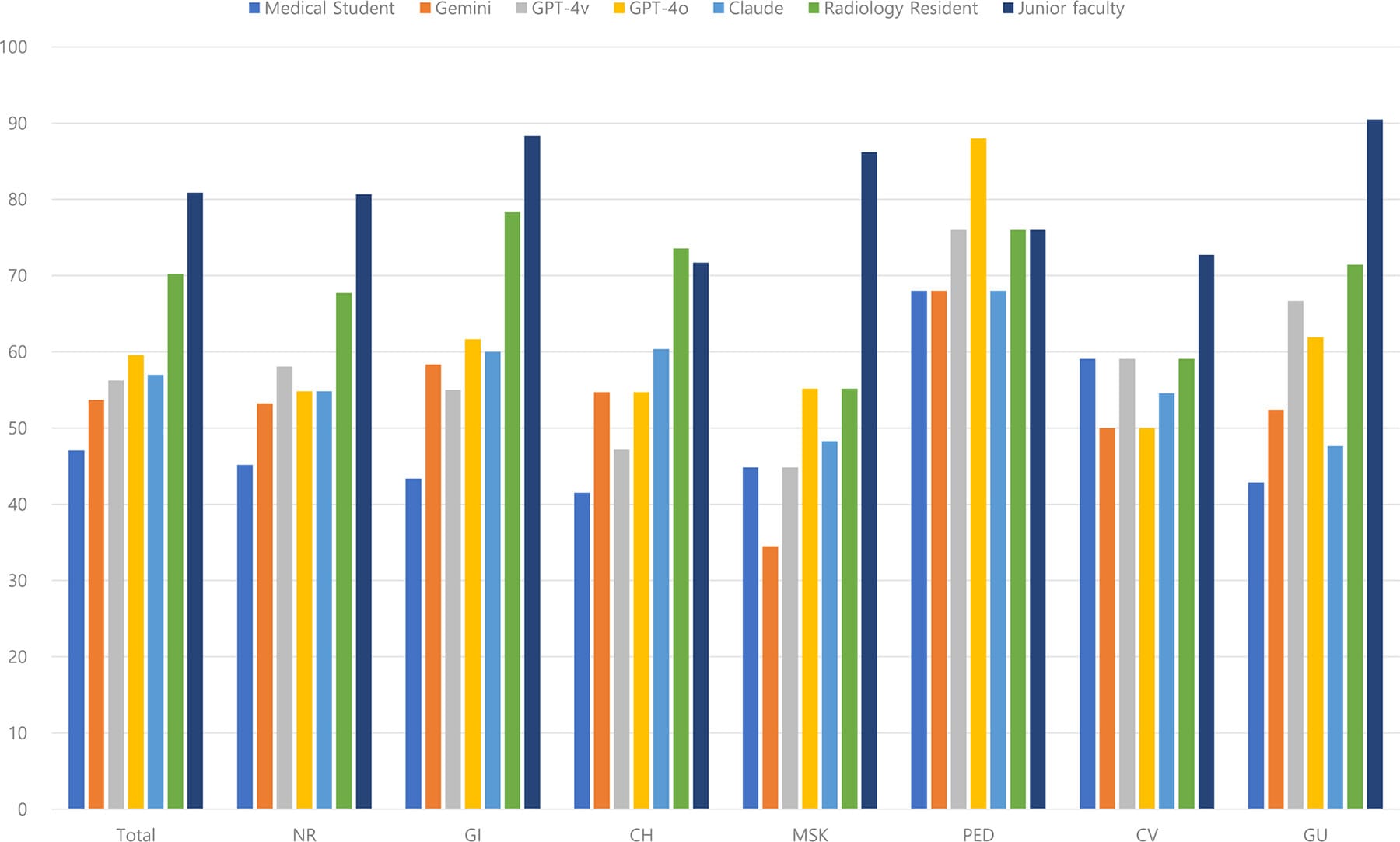

Um estudo comparou a precisão de modelos de linguagem grandes (LLMs) com a de radiologistas humanos em casos do New England Journal of Medicine (NEJM) Image Challenge. O GPT-4 Turbo com Visão (GPT-4V) alcançou 59,6% de acurácia, superando estudantes de medicina (47,1%), mas ficando abaixo de radiologistas juniores (80,9%) e residentes (70,2%). A precisão dos LLMs foi significativamente afetada pelo comprimento do texto de entrada: casos com textos longos (2016–2024) tiveram acurácia 73,1–79,1%, contra 34,8–40,6% em textos curtos (2005–2015). Imagens não melhoraram a precisão dos modelos, levantando dúvidas sobre sua capacidade de interpretação visual.

Questões Estimulantes

- Os LLMs podem substituir radiologistas em diagnósticos por imagem?

- Por que o comprimento do texto influencia tanto a precisão dos LLMs?

- Quais são os riscos de usar LLMs como ferramentas diagnósticas sem supervisão humana?

🗝️ Descomplicando os Conceitos Principais

Introdução

O estudo avaliou a capacidade de LLMs multimodais (como GPT-4V e Claude 3) em interpretar casos clínicos radiológicos do NEJM. Comparou-se sua performance com a de radiologistas juniores, residentes e estudantes de medicina, analisando fatores como entrada de texto, imagens e subespecialidades.

Dimensões do Tema

- LLMs Multimodais: Modelos de IA que processam texto e imagens.

- NEJM Image Challenge: Banco de casos clínicos com desafios diagnósticos baseados em imagens radiológicas.

- Efeito do Texto: Textos longos (com mais contexto clínico) aumentaram a acurácia dos LLMs em até 79,1%.

- Subespecialidades: Radiologistas humanos tiveram desempenho superior em neurologia, gastrointestinal e musculoesquelética.

Figuras e imagens do artigo

Abaixo está as figuras do artigo que mostram o fluxo desde a inclusão de casos no desafio NEJM até a avaliação realizada por humanos e LLMs, bem como demais detalhes. Descrevem o uso dos modelos de linguagem multimodal (LLMs) avaliados: OpenAI’s GPT-4 Omni, GPT-4 Vision, Gemini 1.5 Pro (Google DeepMind) e Claude 3 (Anthropic).

Análise Comparativa: Humanos vs. LLMs

| Aspecto | Vantagens dos LLMs | Limitações dos LLMs |

|---|---|---|

| Precisão | Superaram estudantes de medicina em diagnósticos gerais. | A precisão é inferior à de radiologistas certificados, especialmente em diagnósticos complexos. |

| Dependência do Texto | Entradas textuais detalhadas aumentaram consideravelmente o desempenho. | Desempenho limitado quando as informações textuais são incompletas ou insuficientes. |

| Interpretação de Imagens | Pouca diferença no desempenho com ou sem imagens sugere flexibilidade em diagnósticos baseados em texto. | Fraquezas significativas na análise visual, dificultando interpretações autônomas de imagens radiológicas. |

| Eficiência | LLMs processam casos rapidamente (17 minutos para GPT-4 Omni, contra várias horas de radiologistas). | A rapidez pode comprometer a avaliação de nuances complexas que exigem tempo e análise humana. |

| Foco em Subespecialidades | Excelentes resultados em radiologia pediátrica e casos gerais de ressonância magnética (RM). | Desempenho inconsistente em especialidades como neurorradiologia e radiologia musculoesquelética. |

Fact-Check: Separando Fatos de Suposições

- Precisão dos LLMs supera estudantes de medicina.

✅ Fato: O GPT-4 Omni superou os estudantes de medicina, mas não os radiologistas treinados. - Textos mais longos impulsionam a precisão.

✅ Fato: Dados confirmam que entradas detalhadas aumentam significativamente o desempenho dos LLMs (odds ratio de 3,2 a 6,6). - Imagens são irrelevantes para a precisão dos LLMs.

⚠️ Parcialmente verdade: Embora as imagens não tenham impacto significativo no estudo, isso aponta uma dependência maior do texto e menos habilidade de análise visual. - LLMs superam radiologistas juniores em radiologia pediátrica.

✅ Fato: Apesar da superioridade em precisão nos casos pediátricos, o estudo sugere que isso se deve à natureza comum desses casos. - Casos do NEJM podem estar nos conjuntos de treinamento dos LLMs.

⚠️ Possível, mas não confirmado: A disponibilidade pública dos dados do NEJM levanta dúvidas sobre uma potencial influência nos resultados.

🔍 Perspective Research (Visões Diversificadas)

- [2024] – “GPT-4 em Exames de Radiologia”

- Descrição: GPT-4 acertou 70% das questões do American College of Radiology In-Service Exam, rivalizando com residentes.

- Relevância: Mostra potencial, mas limitações em casos complexos.

- Leia mais.

- [2023] – “Erros Ocultos do GPT-4V em Medicina”

- Descrição: GPT-4V falhou em 30% dos diagnósticos por não interpretar detalhes visuais críticos.

- Relevância: Alerta para riscos em uso clínico sem supervisão.

- Leia mais.

- [2024] – “IA em Radiologia Torácica”

- Descrição: Modelos de IA especializados superaram LLMs gerais em raio-X de tórax.

- Relevância: Sugere necessidade de modelos treinados especificamente para imagens médicas.

- Leia mais.

- [2024] – “Claude 3 em Diagnósticos Oncológicos”

- Descrição: Claude 3 identificou 85% de tumores em MRI, mas com alta taxa de falsos positivos.

- Relevância: Destaca a importância de validação humana.

- Leia mais.

- [2023] – “ChatGPT em Relatórios Radiológicos”

- Descrição: ChatGPT gerou impressões estruturadas com 90% de precisão, reduzindo tempo de trabalho.

- Relevância: Indica utilidade como ferramenta auxiliar, não substituta.

- Leia mais.

Conclusão e Recomendações

Conclusão Geral

LLMs como o GPT-4o têm potencial para auxiliar em diagnósticos radiológicos, especialmente em casos com textos descritivos longos. No entanto, sua precisão é inferior à de radiologistas experientes e varia significativamente entre subespecialidades. A dependência de contexto textual e a limitação na interpretação visual exigem cautela.

Recomendações Práticas

- Para Radiologistas: Use LLMs como ferramentas de apoio, não para decisões autônomas.

- Para Desenvolvedores: Melhore a capacidade de interpretação visual e reduza a dependência de texto.

- Para Gestores: Invista em treinamento combinado (IA + humano) para otimizar fluxos de trabalho.

📋 FAQ: Perguntas Frequentes

1. LLMs podem substituir radiologistas?

Não. Eles superaram estudantes, mas ficaram abaixo de residentes e radiologistas juniores em precisão.

2. Por que textos longos melhoram a precisão?

LLMs usam contexto para inferir respostas, e textos longos fornecem mais detalhes clínicos relevantes.

3. Quais LLMs são mais precisos em radiologia?

GPT-4o teve o melhor desempenho (59,6%), seguido por Claude 3 (57%).

4. Imagens melhoram o desempenho dos LLMs?

Não significativamente. A precisão foi similar com ou sem imagens.

5. Quais subespecialidades têm maior risco de erro?

Musculoesquelética (34–55% de acurácia) e geniturinária (48–71%).