🔗 Buckley, T. A., Crowe, B., Abdulnour, R. E., Rodman, A., & Manrai, A. K. (2025). Comparison of Frontier Open-Source and Proprietary Large Language Models for Complex Diagnoses. JAMA, 2025. DOI: 10.1001/jama.2025.250002

📌 Resumo e Questões Estimulantes

Resumo

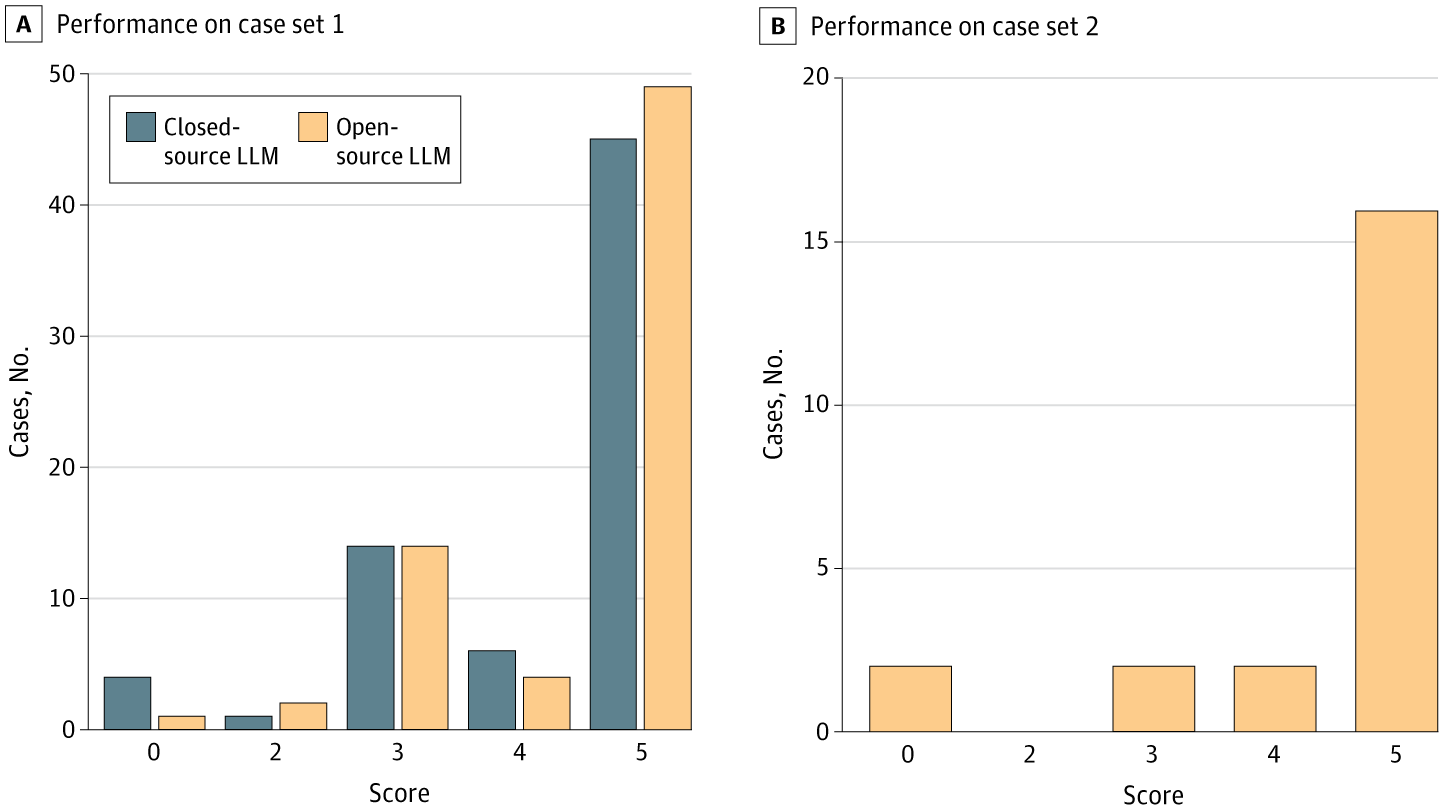

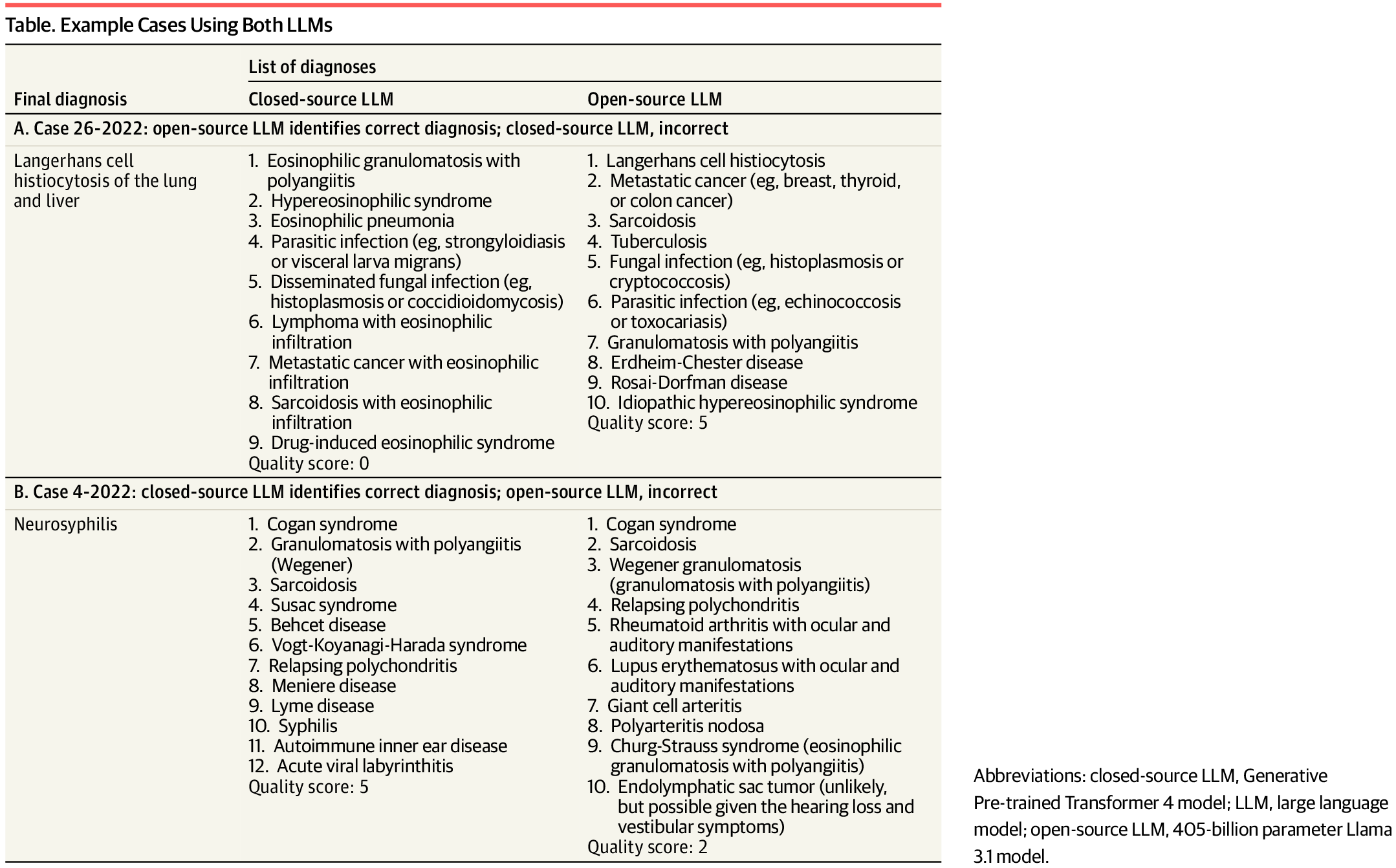

Este estudo comparou a eficácia de um dos modelos de linguagem open source de última geração (Llama 3.1, Meta) com o modelo GPT-4 proprietário da OpenAI em tarefas de diagnóstico clínico complexo. Ao avaliar 92 casos médicos desafiadores, o estudo observou que o modelo open-source apresentou desempenho equiparável ou superior em incluir o diagnóstico correto nas hipóteses diferenciais (70% vs. 64%) e em fornecer a primeira sugestão correta (41% dos casos).

Questões Estimulantes

- Modelos open-source podem superar soluções proprietárias em diagnósticos médicos?

- Como a IA pode impactar a autonomia médica em decisões diagnósticas?

- É possível aplicar modelos open-source em larga escala em sistemas de saúde?

🗝️ Descomplicando os Conceitos Principais

Introdução

A inteligência artificial (IA) já desempenha um papel crucial na medicina, desde a geração de diagnósticos até a triagem clínica. O GPT-4 da OpenAI tem sido líder nesse campo, mas modelos open-source como o Llama 3.1 (Meta) emergem como alternativas competitivas e de acesso livre, com potencial para ampliar o uso da IA em saúde.

Este estudo avaliou esses dois modelos em casos clínicos de alta complexidade, previamente utilizados para testar GPT-4, e também em casos recentes publicados após o treinamento do Llama 3.1, garantindo imparcialidade.

📊 Dimensões do Tema

- Acesso à IA: Modelos open-source podem democratizar o uso da IA em saúde.

- Precisão Diagnóstica: IA pode atuar como segunda opinião médica, aumentando a confiança clínica.

- Viabilidade Clínica: Modelos precisam ser testados em fluxos clínicos reais antes da adoção massiva.

- Ética e Responsabilidade: IA deve ser monitorada quanto a erros e vieses, mesmo em modelos avançados.

🔎 Considerações Práticas

| Aspecto | Descrição |

|---|---|

| Precisão Diagnóstica | O Llama 3.1 incluiu o diagnóstico correto em 70% dos casos e o GPT-4 em 64%. |

| Primeira Sugestão Correta | Llama 3.1 acertou na primeira sugestão em 41% dos casos, desempenho comparável ao GPT-4. |

| Implicação Clínica | Modelos open-source são alternativas viáveis e econômicas para apoiar diagnósticos clínicos. |

| Aplicabilidade Prática | Ideal para ambientes de recursos limitados, com suporte à decisão médica. |

Imagens do Artigo

🆚 Análise Comparativa com Fontes Externas

| Achados do Estudo Atual (2025) | Comparação com Fontes Externas |

|---|---|

| Llama 3.1 superou GPT-4 na inclusão do diagnóstico correto (70% vs 64%). | 📌 Zhang et al. (2024): Mostraram que Llama 3.1 teve desempenho semelhante ou superior ao GPT-4 em resumos clínicos. 🔗 DOI |

| Open-source LLM teve desempenho comparável na primeira sugestão correta (41%). | 📌 Wu et al. (2024): Llama 3 teve resultados comparáveis ao GPT-4 em questões clínicas de nefrologia. 🔗 DOI |

| Modelos open-source podem ser aplicados com menor custo e viés controlado. | 📌 Savage et al. (2024): Destacaram a viabilidade clínica de LLMs open-source com controle ético e maior acesso. 🔗 DOI |

| Resultados consistentes mesmo sem treinamento específico nos casos. | 📌 Adams et al. (2024): Confirmaram que Llama 3 teve alta acurácia em exames simulados de radiologia. 🔗 DOI |

❌ Fact Check

- ✅ Llama 3.1 teve melhor desempenho diagnóstico que GPT-4 em alguns casos?

- Sim. Em diagnósticos complexos, Llama 3.1 superou GPT-4 em inclusão do diagnóstico correto.

- 🔗 Adams et al., 2024

- ❌ Modelos open-source não são adequados para uso clínico?

- Falso. Estudos confirmam sua eficácia comparável, com vantagens em custo e acessibilidade.

- 🔗 Riedemann et al., 2024

- ✅ Open-source LLMs são menos propensos a “alucinações” com dados médicos?

- Sim, em benchmarks restritos, apresentaram menor taxa de erro factual.

- 🔗 Yahaya Alassan et al., 2024

🔍 Perspective Research (Visões Diversificadas)

- “Open-Source vs Proprietários em Resumos Clínicos”(Zhang et al., 2024)

- LLMs open-source mostraram superioridade em compreensão clínica.

- 🔗 DOI

- “Avaliação de Compreensão Clínica em LLMs”(Yahaya Alassan et al., 2024)

- Llama 3 superou GPT-4 em precisão na compreensão de textos médicos.

- 🔗 DOI

- “Desempenho Clínico em Nefrologia”(Wu et al., 2024)

- Avaliação em questões clínicas mostrou equivalência entre Llama e GPT-4.

- 🔗 DOI

- “Implementação Clínica de LLMs”(Savage et al., 2024)

- Defendem uso clínico de LLMs open-source em radiologia e emergências.

- 🔗 DOI

- “Desempenho em Provas Médicas”(Adams et al., 2024)

- Llama 3 teve desempenho superior ao Claude 2 e próximo ao GPT-4.

- 🔗 DOI

📍 Conclusão Geral

O estudo evidencia que modelos de linguagem open-source, como o Llama 3.1, têm desempenho equiparável ou superior ao GPT-4 na tarefa de fornecer diagnósticos diferenciais em casos clínicos complexos. Isso representa um marco na democratização da IA médica, oferecendo opções viáveis, de custo acessível, para instituições com menos recursos. A tecnologia open-source pode acelerar a adoção de ferramentas de suporte à decisão clínica, promovendo mais equidade no acesso à inovação em saúde.

📍 Recomendações Práticas

Pesquisa Colaborativa: Estimular a criação de consórcios internacionais de validação de IA open-source em saúde.

Integração em Ambientes Clínicos: Testar modelos open-source em ambientes hospitalares controlados para suporte à decisão diagnóstica.

Capacitação Profissional: Médicos devem receber treinamento sobre o uso responsável de IA como segunda opinião.

Regulamentação Ética: Desenvolver políticas que garantam a transparência, privacidade e validação clínica antes da adoção em larga escala.

📋 FAQ: Perguntas Frequentes

- IA open-source é tão confiável quanto IA proprietária na medicina?

- Sim. O estudo mostra desempenho comparável em diagnósticos clínicos.

- Modelos como Llama 3.1 estão disponíveis para uso clínico?

- Ainda em testes, mas potencial para uso em hospitais com regulamentação adequada.

- GPT-4 é mais preciso que Llama 3.1?

- Não necessariamente. Este estudo mostrou resultados similares ou melhores com Llama 3.1.