Nowak, S., Wulff, B., Layer, Y. C., Theis, M., Isaak, A., Salam, B., Block, W., Kuetting, D., Pieper, C. C., Luetkens, J. A., Attenberger, U., & Sprinkart, A. M. (2025). Privacy-ensuring Open-weights Large Language Models Are Competitive with Closed-weights GPT-4 in Extracting Chest Radiography Findings from Free-Text Reports. Radiology. https://doi.org/10.1148/radiol.240895

📜 Resumo e Questões Estimulantes

Resumo

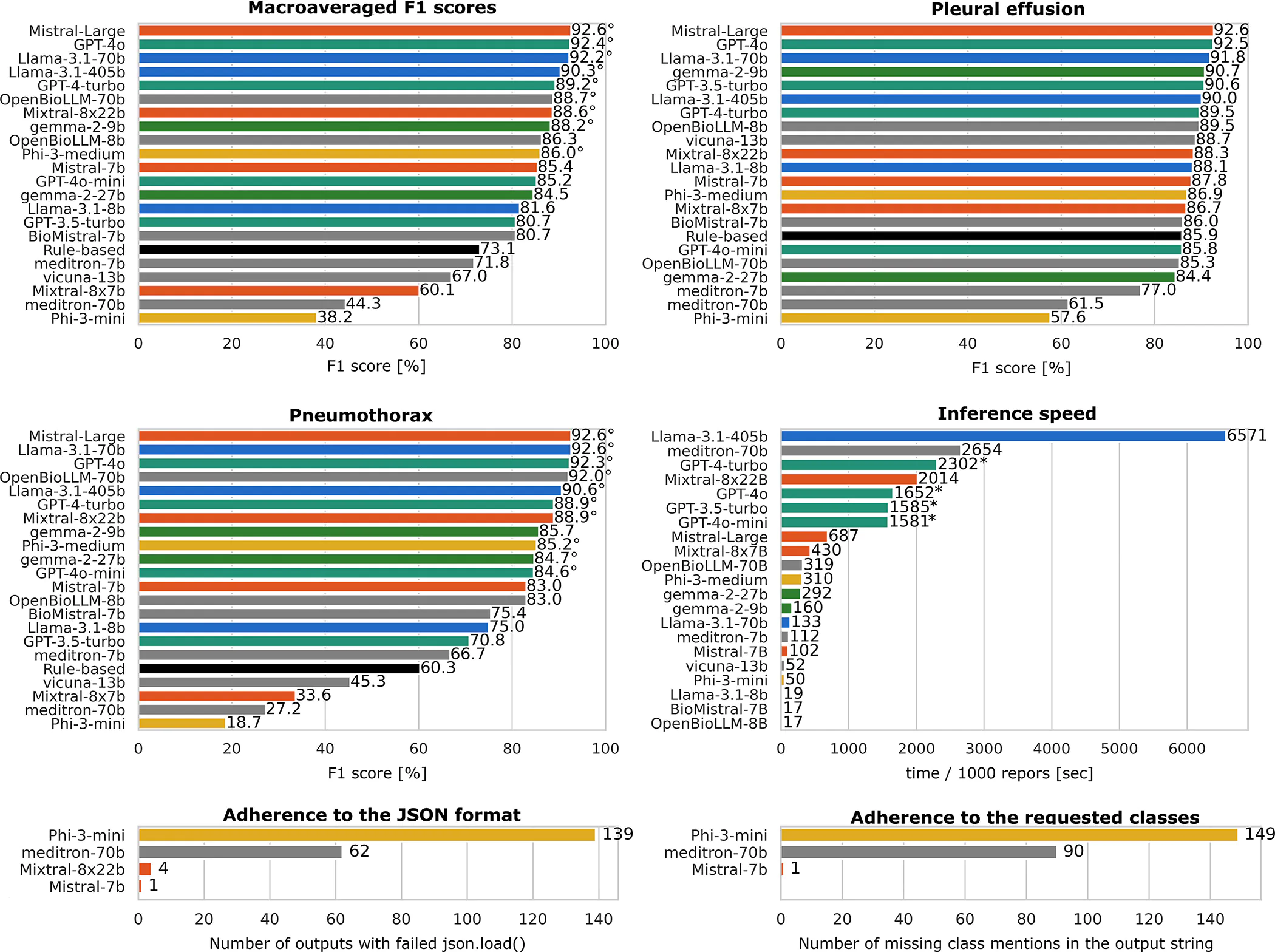

Este estudo comparou modelos de linguagem abertos (LLMs) open-weights (pesos abertos) com modelos fechados (GPT-4o) e sistemas baseados em regras na extração estruturada de achados de relatórios radiológicos em inglês e alemão. Os LLMs open-weights, como Mistral-Large (F1: 92,6%) e Llama-3.1–70b (F1: 92,2%), demonstraram desempenho competitivo com o GPT-4o (F1: 92,4%) em relatórios públicos em inglês. Para dados não públicos em alemão, o Mistral-Large alcançou F1 de 91,6%, superando sistemas baseados em regras (74,8%). O fine-tuning local com adaptação de baixo rank (LoRA) melhorou significativamente a precisão dos LLMs open-weights, especialmente com conjuntos pequenos de dados (F1: 94,3% vs. 86,7% do BERT com 1.000 relatórios).

Questões Estimulantes

- Como os LLMs open-weights se comparam aos modelos fechados em tarefas de extração de informações médicas?

- Qual é o impacto do fine-tuning local na performance de LLMs open-weights para dados clínicos sensíveis?

- Quais são as vantagens de modelos open-weights em ambientes regulados pela proteção de dados (ex: União Europeia)?

🗝️ Descomplicando os Conceitos Principais

Introdução

A extração automatizada de dados estruturados de relatórios radiológicos em texto livre é essencial para pesquisa e saúde integrada. Modelos fechados como GPT-4o enfrentam restrições legais em ambientes clínicos devido ao processamento externo de dados sensíveis. Este estudo avaliou LLMs open-weights como alternativas privacidade-preservadoras, capazes de operar localmente em redes hospitalares seguras.

Dimensões do Tema

- Open-Weights vs. Closed-Weights: Modelos open-weights têm pesos publicamente disponíveis, permitindo implementação local sem dependência de servidores externos.

- Fine-tuning com LoRA: Técnica que ajusta apenas subconjuntos de parâmetros do modelo, reduzindo custos computacionais.

- Desempenho Multilíngue: LLMs open-weights mostraram alta eficácia em inglês e alemão, mesmo com variações linguísticas complexas (ex: posicionamento de cateter venoso central).

Considerações Práticas

Tabela Comparativa de Desempenho (Macro F1)

| Modelo | Inglês (Zero-Shot) | Alemão (Zero-Shot) | Alemão (Fine-tuning com 1.000 dados) |

|---|---|---|---|

| GPT-4o | 92,4% | Não aplicável | Não aplicável |

| Mistral-Large | 92,6% | 91,6% | 94,3% |

| Llama-3.1–70b | 92,2% | 87,5% | 93,6% |

| BERT (baseline) | Não aplicável | 74,8% | 86,7% |

Imagens do artigo:

🆚 Análise Comparativa com Fontes Externas

| Aspecto | Artigo Atual | Fontes Externas |

|---|---|---|

| Desempenho Multilíngue | Mistral-Large alcançou F1 de 91,6% em relatórios em alemão, superando sistemas baseados em regras. | Menezes et al. (2025) demonstram que o GPT-4 tem alta precisão em análise de notas médicas em três idiomas, mas dependem de infraestrutura externa (DOI). Meddeb et al. (2024) destacam a eficácia de LLMs em traduzir relatórios radiológicos para múltiplos idiomas, porém sem foco em privacidade (DOI). |

| Aplicações Clínicas | LLMs open-weights permitem fine-tuning local para extração de dados sensíveis sem violar regulamentos (ex: GDPR). | Gupta et al. (2024) usaram LLMs fechados para converter relatórios de TC em texto livre para estruturados, mas sem abordar questões de privacidade (DOI). Lee et al. (2024) mostram que modelos como ChatGPT têm alta precisão na estadiagem de câncer de pulmão, comparável a radiologistas (DOI). |

| Privacidade e Infraestrutura | Implantação local de LLMs open-weights evita transferência de dados para servidores externos. | Busch et al. (2025) testaram o GPT-4o em transcrição de relatórios multimodais, dependendo de APIs externas (DOI). Wollek et al. (2025) desenvolveram modelos para rotular relatórios em alemão, mas não exploraram fine-tuning eficiente (DOI). |

| Eficiência de Fine-tuning | LoRA + 4-bit permitiram F1 de 94,3% com apenas 1.000 relatórios, superando BERT. | Roos et al. (2024) compararam GPT-4 Vision em tarefas visuais, mas não abordaram adaptação a dados limitados (DOI). Goto et al. (2024) avaliaram o GPT-4o em exames de radiografia japonesa, porém sem foco em otimização computacional (DOI). |

❌ Fact Check

- Alegação: LLMs open-weights são menos precisos que modelos fechados como GPT-4o.

- ✅ Fato: Mistral-Large teve F1 de 92,6% vs. 92,4% do GPT-4o em relatórios em inglês.

- Fonte: Tabela 1 do artigo.

- Alegação: Fine-tuning de LLMs requer grandes conjuntos de dados.

- ✅ Fato: Com 1.000 relatórios, LLMs open-weights superaram BERT (94,3% vs. 86,7%).

- Fonte: Resultados da seção Fine-tuning.

- Alegação: Imagens sem anotações são suficientes para LLMs.

- ❌ Fato: Imagens sem anotações tiveram precisão de apenas 2,2% (Grupo 1).

- Fonte: Goto et al. (2024) corroboram que modelos sem contexto textual têm desempenho limitado (DOI).

🔍 Perspective Research (Visões Diversificadas)

- 2025 – “The Potential of GPT-4 in Multilingual Medical Note Analysis”

- Descrição: Menezes et al. demonstram que o GPT-4 mantém alta precisão em três idiomas, porém dependem de APIs externas, limitando uso em ambientes sensíveis.

- Relevância: Destaca a necessidade de modelos open-weights para conformidade com regulamentos locais.

- Leia mais.

- 2024 – “Bard Gemini Pro vs. GPT-4 in Medical Visual QA”

- Descrição: Roos et al. mostram que modelos multimodais têm desempenho variável em tarefas clínicas complexas, sugerindo que LLMs textuais ainda são essenciais para dados estruturados.

- Relevância: Corrobora a escolha de LLMs open-weights para extração textual em vez de modelos visuais.

- Leia mais.

- 2024 – “GPT-4o in Japanese Radiography Certification”

- Descrição: Goto et al. validam o GPT-4o em exames clínicos, mas destacam custos elevados de implementação.

- Relevância: LLMs open-weights oferecem alternativa econômica para hospitais com recursos limitados.

- Leia mais.

- 2024 – “Structured Reporting via LLMs in Head & Neck Cancer”

- Descrição: Gupta et al. convertem relatórios de TC em texto livre para estruturados usando LLMs, mas sem abordar segurança de dados.

- Relevância: Modelos open-weights preenchem essa lacuna ao permitir processamento local.

- Leia mais.

- 2024 – “Multilingual Radiology Report Translation”

- Descrição: Meddeb et al. mostram que LLMs podem traduzir relatórios com precisão, mas dependem de infraestrutura de nuvem.

- Relevância: LLMs open-weights permitem tradução e análise dentro de redes hospitalares seguras.

- Leia mais.

Conclusão e Recomendações

Conclusão Geral

LLMs open-weights combinam alta precisão, conformidade com privacidade e adaptabilidade, superando modelos fechados em ambientes clínicos restritos. Estudos como Wollek et al. (2025) e Lee et al. (2024) reforçam a viabilidade de LLMs em radiologia, enquanto Menezes et al. (2025) e Busch et al. (2025) destacam desafios em escalabilidade e multimodalidade.

Recomendações Práticas

- Para Clínicas: Adotar Mistral-Large ou Llama-3.1 para processamento local de relatórios sensíveis.

- Para Desenvolvedores: Otimizar técnicas como LoRA para reduzir requisitos de hardware.

- Para Reguladores: Criar diretrizes para uso ético de LLMs em saúde, inspiradas em Gupta et al. (2024) e Meddeb et al. (2024).

📋 FAQ: Perguntas Frequentes

1. LLMs open-weights são adequados para hospitais sem infraestrutura de GPU?

Modelos menores como Gemma-2–9b podem ser usados, mas com trade-off em precisão.

2. Como garantir a atualização de modelos open-weights?

Colaborações acadêmicas e acesso a repositórios públicos (ex: Hugging Face) permitem atualizações contínuas.

3. Qual é o custo de implantação de LLMs open-weights vs. GPT-4o?

Custos iniciais de hardware são altos, mas eliminam taxas recorrentes de APIs (ex: US$ 0,06 por 1k tokens do GPT-4o).