Kim, S., Kim, D., Shin, H. J., Lee, S. H., Kang, Y., Jeong, S., Kim, J., Han, M., Lee, S.-J., Kim, J., Yum, J., Han, C., & Yoon, D. (2025). Large-Scale Validation of the Feasibility of GPT-4 as a Proofreading Tool for Head CT Reports. Radiology. https://doi.org/10.1148/radiol.240701

📌 Resumo e Questões Estimulantes

Resumo

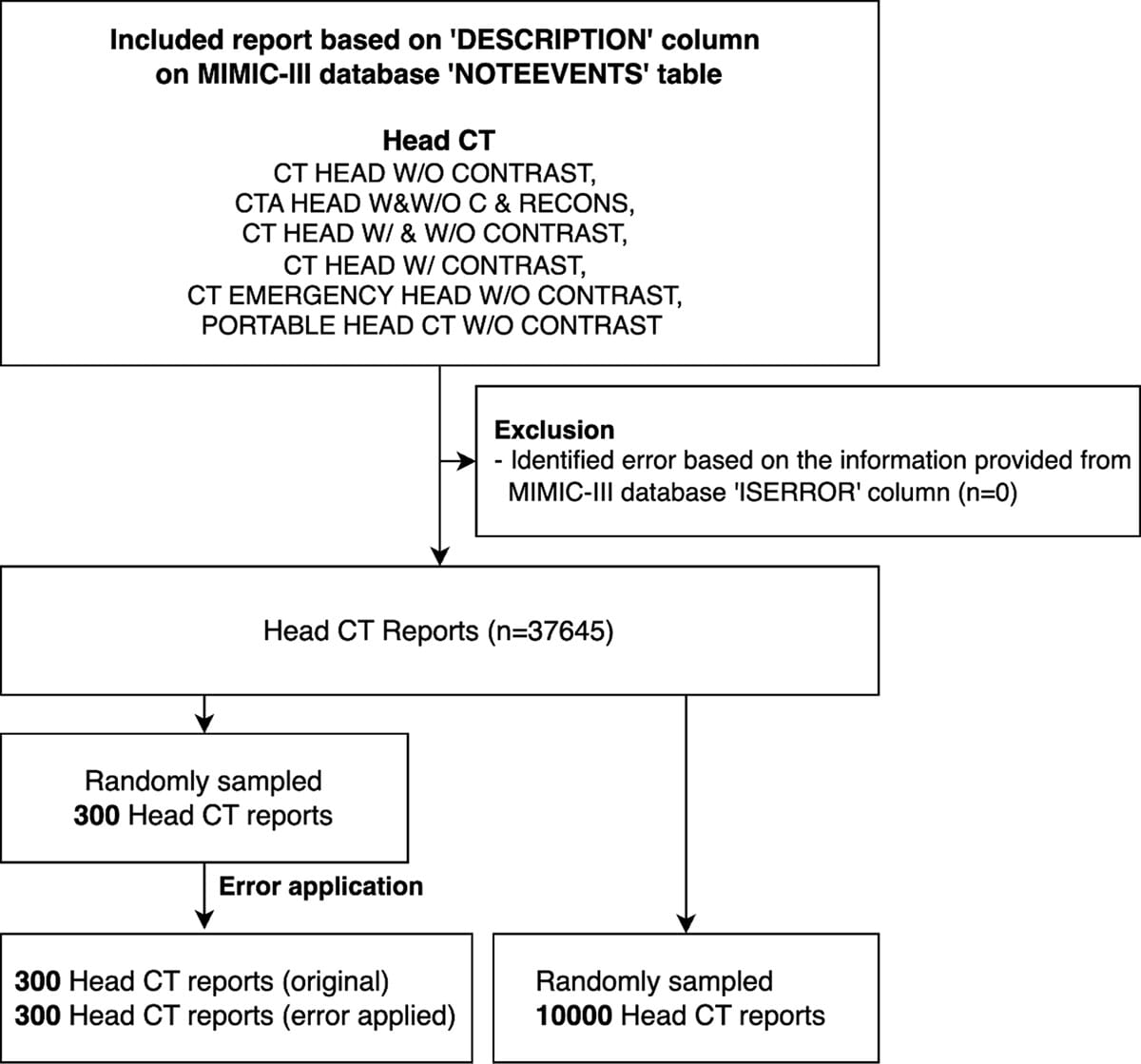

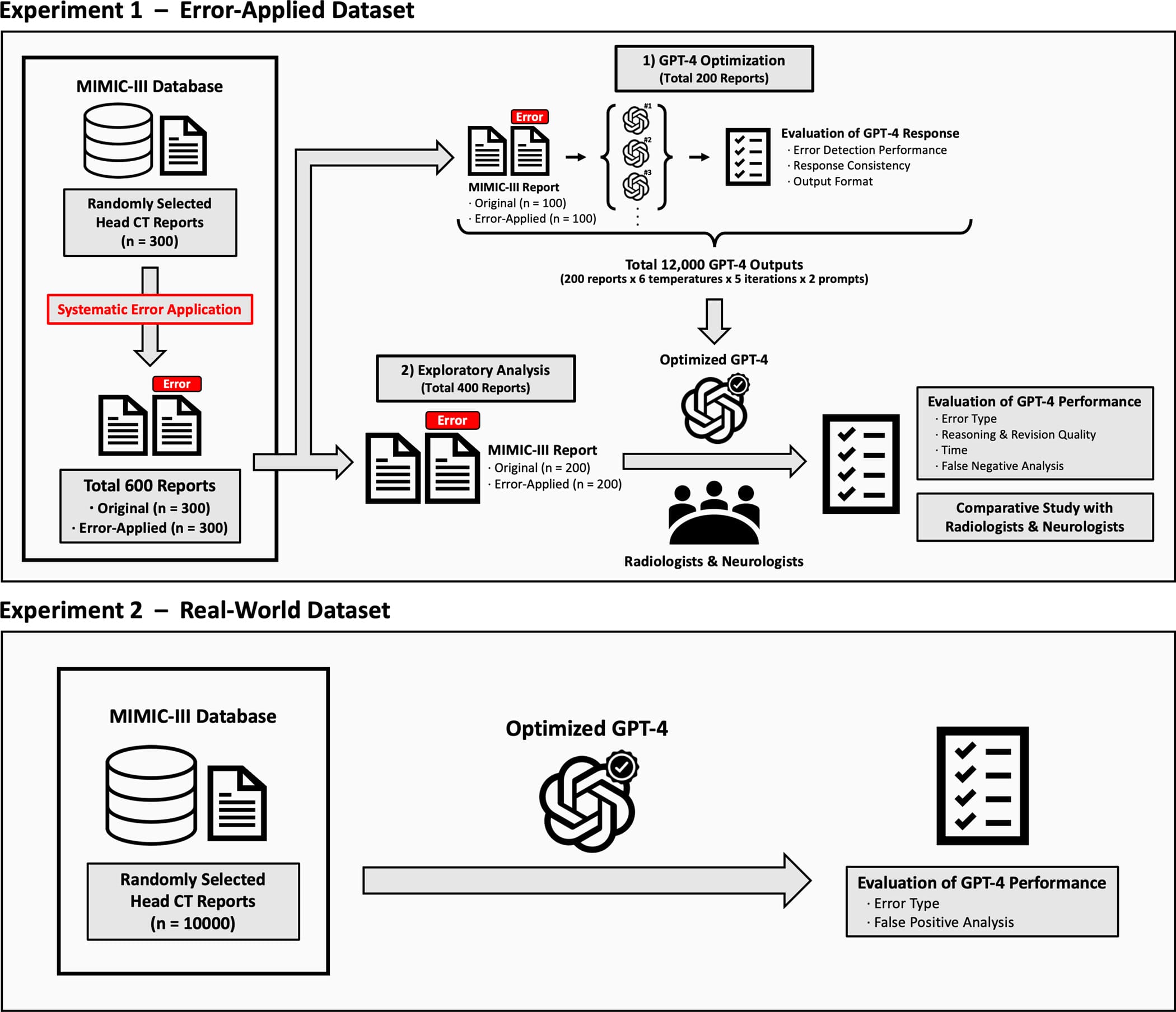

O crescente volume de exames de imagem tem sobrecarregado radiologistas, resultando em aumento de erros nos relatórios. Modelos de linguagem de grande escala, como o GPT-4, surgem como ferramentas promissoras para detecção e correção de erros nesses relatórios. Este estudo avalia a viabilidade do GPT-4 na revisão de relatórios de TC de crânio, comparando seu desempenho com radiologistas humanos.

Questões Estimulantes

- O GPT-4 pode detectar erros nos relatórios radiológicos com maior precisão que os humanos?

- O modelo é eficaz na correção de erros interpretativos e factuais?

- Como o GPT-4 pode otimizar a carga de trabalho dos radiologistas sem comprometer a precisão diagnóstica?

📖 Descomplicando os Conceitos Principais

Introdução

A revisão de relatórios radiológicos é uma etapa essencial para evitar erros diagnósticos que possam impactar o tratamento dos pacientes. Este estudo propõe avaliar a viabilidade do GPT-4 para revisão de relatórios de TC de crânio, comparando sua sensibilidade e especificidade com a de radiologistas humanos.

Dimensões do Tema

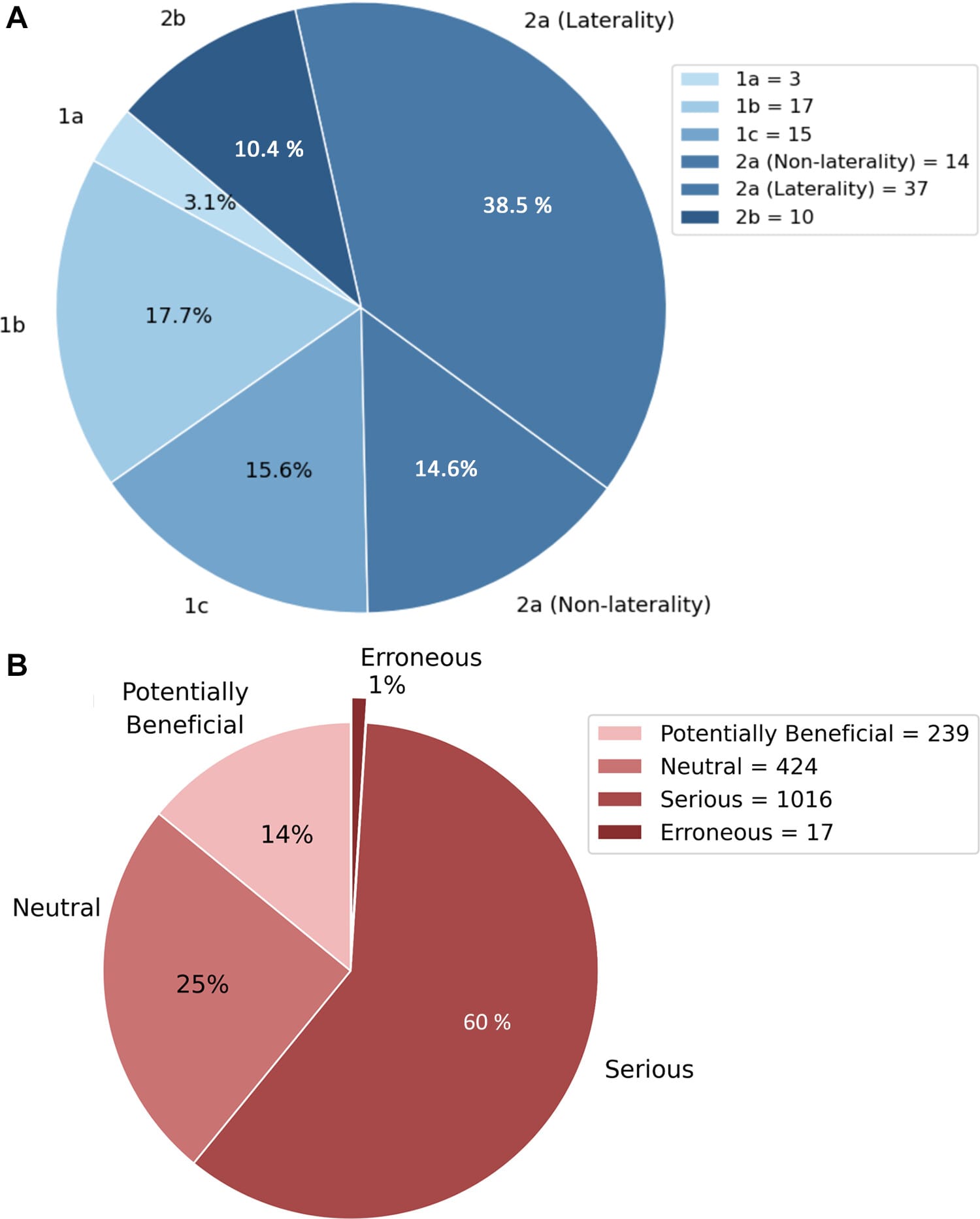

Os erros em relatórios radiológicos podem ser divididos em:

- Erros interpretativos – Falhas na interpretação das imagens.

- Erros factuais – Discrepâncias nos detalhes descritivos do relatório.

O GPT-4 é analisado quanto à sua capacidade de:

- Detectar erros radiológicos

- Raciocinar sobre os erros

- Corrigir as falhas detectadas

Considerações Práticas

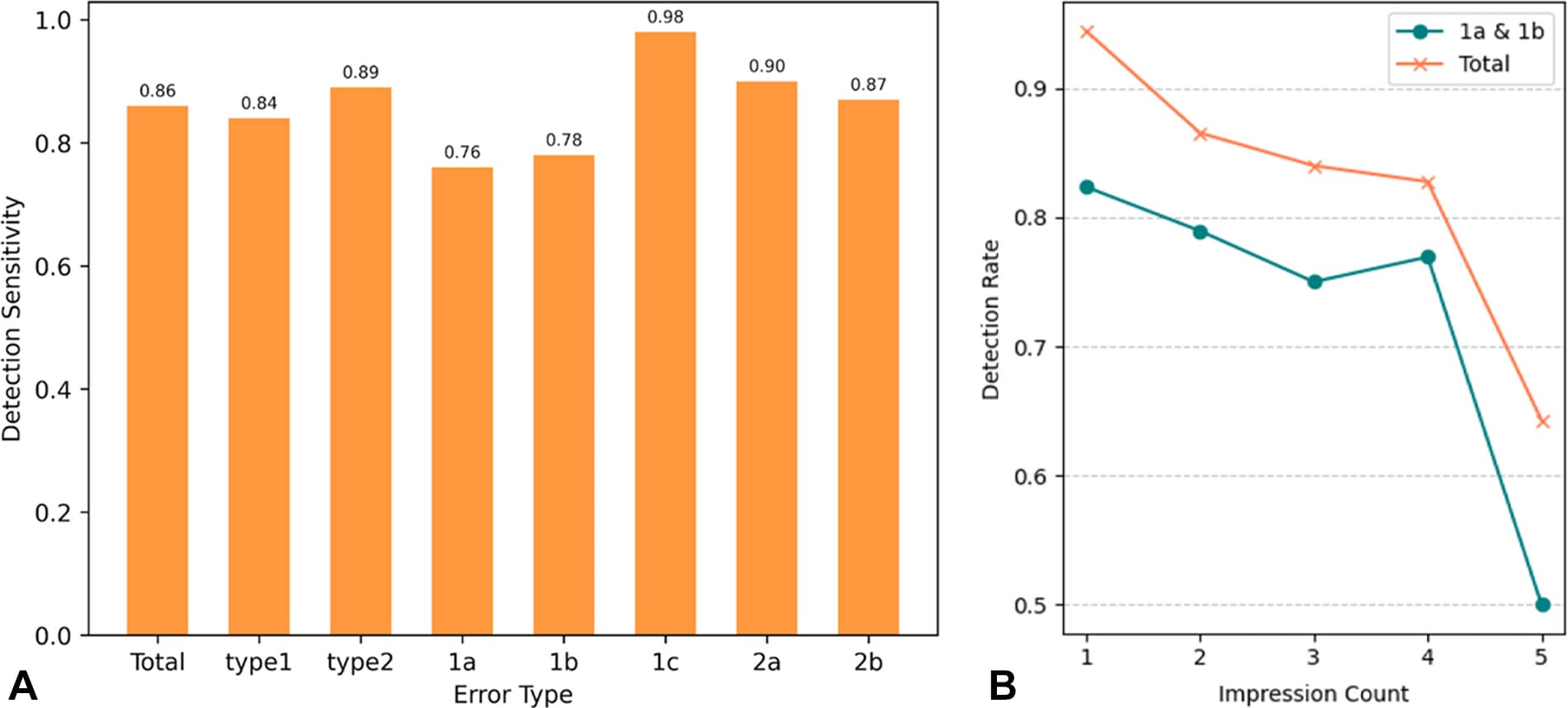

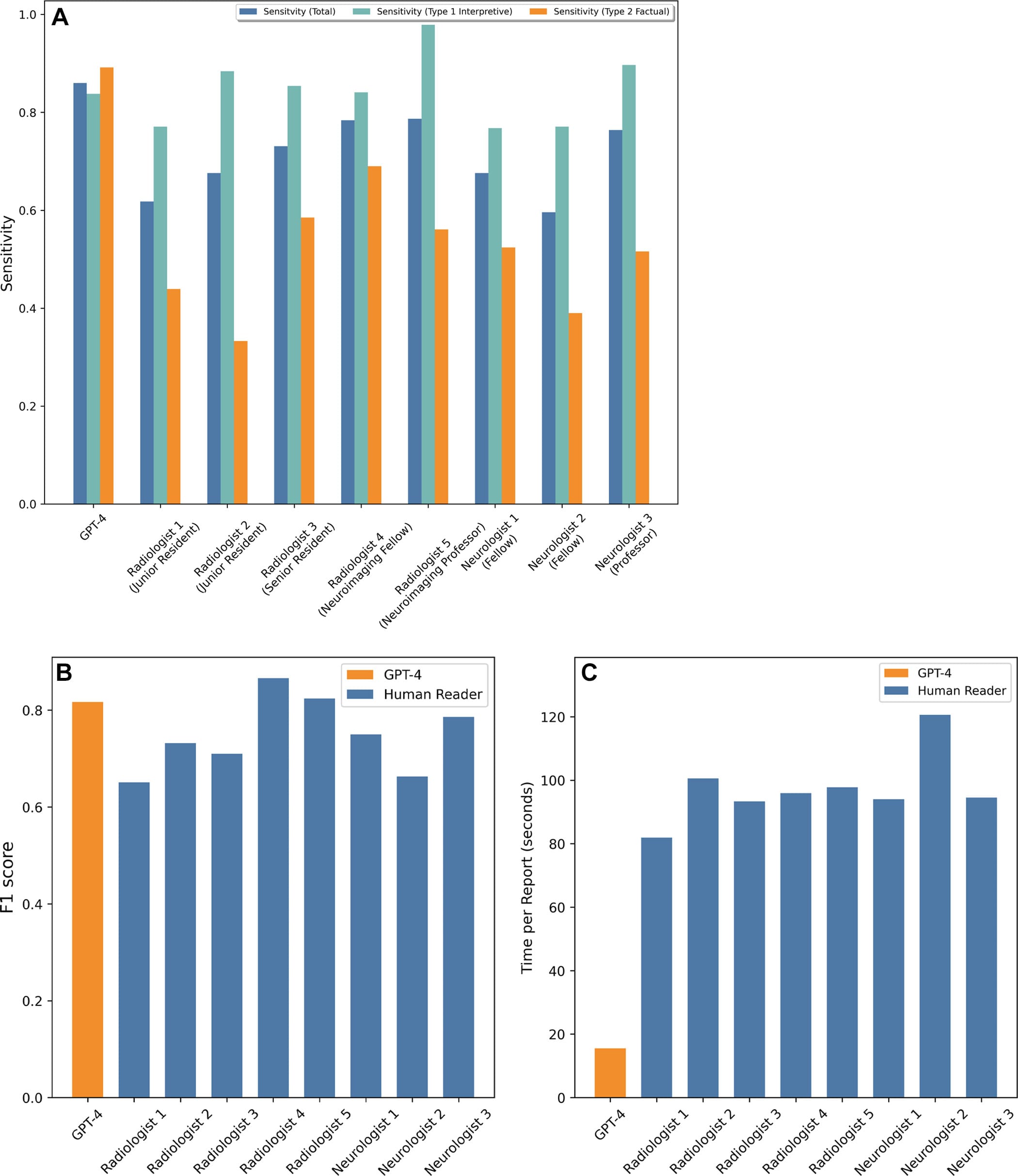

Tabela 1: Comparação de Sensibilidade na Detecção de Erros

| Tipo de Erro | Sensibilidade GPT-4 | Sensibilidade Radiologistas |

|---|---|---|

| Erro interpretativo | 84% | 77% – 98% |

| Erro factual | 89% | 33% – 69% |

| Tempo médio de revisão | 16 segundos | 82 – 121 segundos |

- O GPT-4 superou os humanos na detecção de erros factuais.

- Radiologistas tiveram desempenho superior em erros interpretativos.

- O tempo de revisão do GPT-4 foi significativamente menor do que o dos radiologistas.

Figuras do Artigo:

Direções Futuras

- Integração do GPT-4 como ferramenta de auxílio na revisão de relatórios.

- Aperfeiçoamento do modelo para priorizar achados clínicos mais relevantes.

- Desenvolvimento de algoritmos híbridos combinando IA e supervisão humana.

🆚 Análise Comparativa com Fontes Externas

| Aspecto | Insights do Artigo | Perspectivas de Fontes Externas |

|---|---|---|

| Impacto da Carga de Trabalho na Radiologia | O excesso de exames impacta negativamente a precisão diagnóstica. | RSNA (2024): A sobrecarga radiológica aumenta erros em relatórios médicos. Leia mais |

| Detecção de Erros com Modelos de IA | IA pode identificar erros em relatórios com eficiência comparável a humanos. | Sun et al. (2023): GPT-4 gera laudos com qualidade semelhante aos de especialistas. Leia mais |

| Comparação GPT-4 vs Radiologistas | O GPT-4 tem melhor desempenho na detecção de erros factuais, mas dificuldade em priorizar achados clínicos. | Kim et al. (2025): GPT-4 é mais rápido que radiologistas, mas precisa de refinamento para análise clínica. Leia mais |

| Uso de IA para Relatórios Estruturados | Modelos GPT podem automatizar a estruturação de laudos médicos. | Elkassem et al. (2023): IA auxilia na geração de relatórios radiológicos com formatação otimizada. Leia mais |

| Personalização de Relatórios para Pacientes | Modelos GPT podem melhorar a comunicação com os pacientes. | Fink et al. (2023): IA pode ser usada para tornar os laudos mais compreensíveis para pacientes. Leia mais |

🔍 Perspective Research (Visões Diversificadas)

| Ano | Estudo | Conclusão / Descoberta |

|---|---|---|

| 2021 | Artificial Intelligence Enabling Radiology Reporting – Bizzo et al. | A inteligência artificial já está aprimorando a geração de relatórios radiológicos, reduzindo o tempo de resposta. Leia mais |

| 2021 | Review of Artificial Intelligence Training Tools and Courses for Radiologists – Richardson et al. | O treinamento de IA para radiologistas ainda é limitado, exigindo mais padronização e validação. Leia mais |

| 2023 | Potential Use Cases for ChatGPT in Radiology Reporting – Elkassem et al. | Modelos de linguagem podem ser usados na estruturação automática de relatórios radiológicos. Leia mais |

| 2023 | Evaluating GPT-4 on Impressions Generation in Radiology Reports – Sun et al. | O GPT-4 consegue gerar laudos radiológicos com qualidade comparável a laudos humanos. Leia mais |

🔎 Conclusão e Recomendações

Conclusão Geral

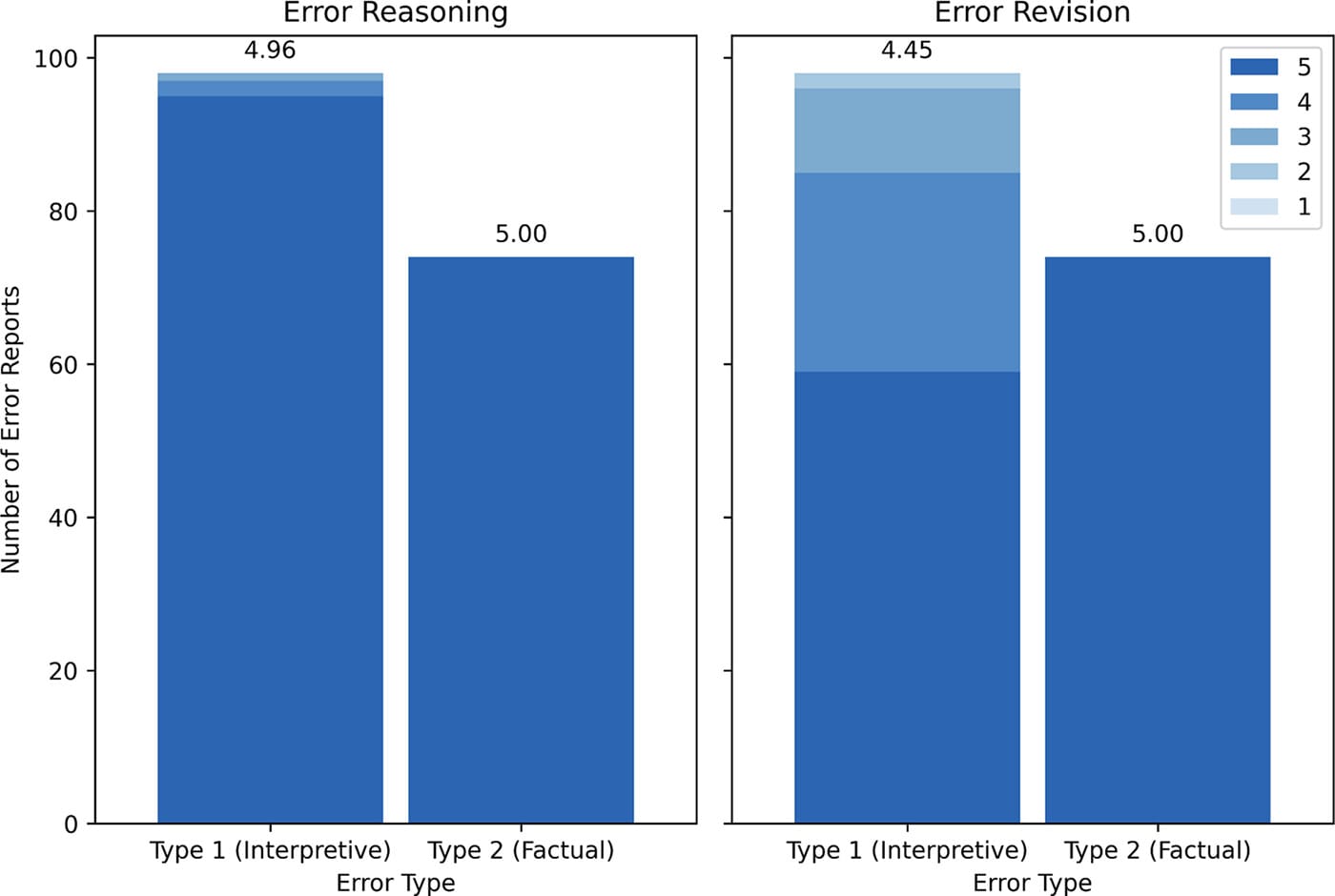

O GPT-4 se mostrou um recurso valioso para revisão de relatórios de TC de crânio, com alta precisão na detecção de erros factuais. No entanto, sua capacidade de priorizar achados clínicos ainda requer melhorias.

Recomendações Práticas

✔️ Uso híbrido: IA para detecção de erros e humanos para interpretação clínica.

✔️ Aprimoramento de prompts: Ajustes para reduzir a taxa de falsos positivos.

✔️ Expansão para outras modalidades: Aplicação em RM, ultrassonografia, etc.

📋 FAQ: Perguntas Frequentes

🔹 O GPT-4 pode substituir um radiologista?

❌ Não, a IA auxilia na revisão, mas a interpretação final deve ser feita por especialistas.

🔹 Quais são os principais desafios do GPT-4 na revisão de relatórios?

📌 Priorizar achados clínicos e reduzir a taxa de falsos positivos.

🔹 O GPT-4 pode ser usado para outros exames de imagem?

✔️ Sim, mas estudos adicionais são necessários para validar seu uso em outras modalidades.